|

Kritik der

neoklassischen Wirtschaftslehre Der ökonomiekritische Diskurs des CambridgeÖkonomen Piero Sraffa. Aus Anlaß des 50jährigen Jubiläums seines Hauptwerkes. von HansPeter Büttner |

10/10 |

|

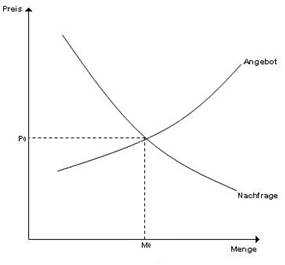

1. Der Ausgangspunkt § 1. Die heutzutage global dominierende ökonomische Theorie ist die sog. Schule der „Neoklassik“. Sie wird so genannt, weil sie den älteren, hauptsächlich von dem klassischen, schottischen Nationalökonomen Adam Smith (17231790) stammenden Grundgedanken von der wohlstandsfördernden Wirkung der „unsichtbaren Hand“, die praktisch hinter dem Rücken der streng egoistisch und profit bzw. nutzenmaximierend handelnden ökonomischen Einzelakteure eine harmonische Ordnung konstituiert, neu formulierte.[1] Mit der Klassik verbindet die NeoKlassik der Glaube an die Harmonie und Effizienz fördernde Tendenz der Marktkräfte – was sie dagegen von ihr trennt, ist die ökonomische Begründung dieses Axioms. Die neoklassische Theorie baut zentral auf der formal vereinheitlichten Theorie des Haushalts und der Konsumsphäre einerseits und des Unternehmens und der Produktionssphäre andererseits auf. In der Haushaltstheorie herrscht das streng rational seinen Nutzen über Wahlhandlungen zwischen unterschiedlich bewerteten Konsumalternativen maximierende Haushaltssubjekt und in der Unternehmenstheorie das rational seinen Gewinn ebenfalls über Wahlhandlungen zwischen Produktionsalternativen maximierende Unternehmen. Die Entscheidungssituation ist hierbei bei Unternehmen wie Haushalten weitgehend analog formalisiert. So entsprechen die Nutzenfunktionen der Haushaltstheorie in ihrem formalen Aufbau exakt den Produktionsfunktionen der Unternehmenstheorie.[2] § 2. Wenn Haushalte und Unternehmen sich nun auf Märkten treffen, um sowohl die von den Haushalten angebotene „Ware Arbeitskraft“ (auf „Arbeitsmärkten“) als auch die von den Unternehmen angebotenen Konsumgüter (auf Konsumgütermärkten) zu tauschen, bilden sich die Preise nach herrschender Lehre entsprechend Angebot und Nachfrage heraus. Weil diese Preisbildung auf einen bestimmten Markt mit einem bestimmten Produkt beschränkt ist, wird in diesem Zusammenhang von der „partiellen Gleichgewichtstheorie“ gesprochen und nicht von der „allgemeinen Gleichgewichtstheorie“, bei der alle Märkte gleichzeitig als Gesamtsystem betrachtet werden. Es wird dabei in der partiellen Gleichgewichtstheorie davon ausgegangen, dass mit zunehmender Menge des auf dem Markt gehandelten Gutes die Nachfragekurve sinkt[3] und die Angebotskurve steigt. Grafik 1 zeigt die typischen, in nahezu allen Standard Lehrbüchern aufgeführten Kurven in ihrer Verlaufsform:[4]

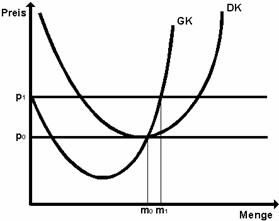

Grafik 1 Wir sehen hier die steigende Angebots und die fallende Nachfragekurve und ihren Schnittpunkt, dem die Menge M0 und der Preis P0 entsprechen. Um nun den Verlauf der Angebotskurve – die Nachfragekurve wäre gesondert zu betrachten[5] – zu erklären, muss die ökonomische Theorie einige nur ganz selten genauer betrachtete Unterstellungen bezüglich der Kostenverläufe in den produzierenden Unternehmen vornehmen. Die Angebotskurve steigt nämlich nicht aus dem Grund, dass die Unternehmen bei steigenden Preisen mehr Gewinn machen oder einfach mit steigender Menge automatisch höhere Preise einfordern können, sondern weil ein bestimmter, rein technologisch determinierter Kostenverlauf unterstellt wird, welcher bei Ausweitung der Produktion zu überproportionaler Kostensteigerung führt – der ökonomische Gewinn ist nämlich per definitionem auf jedem Punkt der Angebotskurve gleich Null. Dies bedeutet nicht, dass in der Unternehmensbilanz kein Gewinn auftauchen würde, sondern dass der unternehmerische Gewinn ganz und gar „leistungsbezogen“ ist, also den produktiven Leistungen des „Produktionsfaktors Kapital“ entspricht. In diesem Sinn kennt die Neoklassik gar keine dauerhaften „Gewinne“ oder „Profite“, sondern nur faktorgerechte Entlohnungen für den jeweiligen Beitrag zur Herstellung eines Endproduktes. Der Wettbewerbsdruck bringt praktisch jegliche über den tatsächlichen Faktorbeitrag zum Endprodukt hinausgehenden „Extragewinne“ zum Verschwinden. Prinzipiell ist das AngebotsNachfrageSchema identisch sowohl auf Gütermärkten als auch auf dem Arbeitsmarkt. Auf dem Arbeitsmarkt steigt die Angebotskurve mit steigendem Lohn und fällt mit sinkendem. Die Nachfragekurve verhält sich genau entgegengesetzt: bei fallendem Lohnniveau fragen die Unternehmen mehr Arbeit nach, bei steigendem Lohnniveau geht die Nachfrage nach Arbeitskraft zurück. Es dürfte allerdings klar sein, dass die Konstruktion der ArbeitsAngebotskurve überaus dubios ist, denn wenn wir voraussetzen, dass Menschen von ihren Löhnen auch Leben müssen, werden Haushalte im unteren Lohnniveau ihr Angebot ausweiten statt einschränken. Umgekehrt werden Menschen im obersten Lohnbereich irgendwann kein Interesse mehr haben, länger zu arbeiten, sondern ihr Angebot einschränken. Im Endergebnis kann die Angebotskurve derart von den neoklassischen Standardannahmen abweichen, dass Angebots und Nachfragekurve sich mehrfach schneiden und keine eindeutigen Gleichgewichte mehr existieren.[6] 2. Ertragsgesetz und Unternehmenstheorie § 3. Die Angebotskurve der Unternehmen wurde nun in den zwanziger Jahren des 20. Jahrhunderts von dem im Jahre 1927 aus Italien nach Cambridge/GBR emigrierten Ökonomen Piero Sraffa einer radikalen, immanenten Kritik ihrer eigenen methodologischen Grundlagen unterzogen[7]. Sraffa bezog sich seinerzeit noch v.a. auf die Lehrbuchdarstellung des britischen Ökonomen Alfred Marshall (18421924), des „Urvaters“ der modernen AngebotsNachfrageDiagramme. Die steigende Angebotskurve begründet sich ursprünglich über das von dem französischen Ökonomen Anne Robert Jacques Turgot (17171781) im 18. Jahrhundert im Zusammenhang landwirtschaftlicher Studien aufgestellte sog. „Ertragsgesetz“. Dieses Gesetz besagt, dass eine gegebene, invariante Bodenmenge im Verlauf ihrer Bearbeitung zuerst steigende und dann fallende Erträge aufweist. Wichtig ist hierbei, dass bei Ausweitung der Produktion fallende Erträge steigende Kosten und steigende Erträge wiederum fallende Kosten implizieren. Das Ertragsgesetz wurde nun im Rahmen der neoklassischen Revolutionierung der ökonomischen Theorie und der Verallgemeinerung des Prinzips von Angebot und Nachfrage auf die industrielle Produktion übertragen. Dieses „industrielle Ertragsgesetz“ schlägt für die Neoklassik hierbei gewissermaßen drei „Fliegen mit einer Klappe“, denn es erlaubt sowohl die Bestimmung der optimalen Unternehmensgröße durch den Schnittpunkt der uförmig verlaufenden Kostenkurve mit der durch den Markt vorgegebenen horizontalen Preisgerade des Marktpreises p0[8], als auch die Erfüllung der Bedingungen eines „vollkommenen“, wohlfahrtstheoretisch optimalen Wettbewerbszustandes. Drittens werden so die Bedingungen für die Gültigkeit der Grenzproduktivitätstheorie der Verteilung geschaffen, denn um „Grenzprodukte“ zu ermitteln, dürfen die Produktionsfaktoren nicht fest aneinander gekoppelt sein wie im Fall sog. „limitationaler Produktionsfunktionen“. Das „industrielle Ertragsgesetz“ impliziert genau jene für die Geltung der Grenzproduktivitätstheorie notwendige Möglichkeit der partiellen Faktorvariation und der dadurch ermittelten Grenzproduktivität des variablen Faktors. Sehen wir uns diesen Zusammenhang kurz an in Grafik 2:

Grafik 2 „GK“ bezeichnet die Kurve der Grenzkosten, also nur die Kosten der jeweils letzten produzierten Einheit. „DK“ wiederum bezeichnet die Durchschnittskosten, also die Summe der Grenzkosten dividiert durch die Anzahl aller produzierten Einheiten bis zum jeweiligen Punkt. Beide Kurven verlaufen, wie wir sehen, uförmig, also ertragsgesetzlich. Die Grenzkostenkurve schneidet die Durchschnittskostenkurve im unteren Scheitelpunkt der letzteren, wenn also die Durchschnittskosten minimal und den Grenzkosten gleich sind. Dieser Punkt wird auch „Betriebsoptimum“ oder „Punkt der effizientesten Produktionsmenge“ genannt, denn bei niedrigerer Produktionsmenge ist die jeweils nächste produzierte Einheit noch kostengünstiger als der Kostendurchschnitt und bei höherer Produktionsmenge sind die Kosten der jeweils nächsten produzierten Einheit höher als die Durchschnittskosten aller bisher produzierten Einheiten. Ein gewinnorientiertes Unternehmen wird folglich anstreben, stets im „Betriebsoptimum“ zu produzieren, in dem die Grenzkosten gleich den minimalen Durchschnittskosten sind.[9] Der Marktpreis p0 wiederum schneidet den Punkt des Betriebsoptimums deshalb, weil im Gleichgewicht kein Extragewinn wie auch kein Verlust auf der Unternehmensebene auftritt. Würde der Marktpreis beispielsweise wie p1 als Gerade oberhalb des Betriebsoptimums verlaufen, würde das Unternehmen – im Schnittpunkt der Grenzkostenkurve mit p1 – die Menge m1 produzieren. In diesem Punkt liegen aber die Durchschnittskosten (und damit die Gesamtkosten) unterhalb der Gesamterlöse, so dass ein Überschußgewinn anfällt. Damit der Extragewinn entfällt und ein partielles Gleichgewicht entsteht, wird folglich angenommen, dass zusätzliche Unternehmen in den Markt eintreten und so die Produktionsmenge der gesamten Branche steigt mit dem Ergebnis eines fallenden Marktpreises. Idealiter wird diese Bewegung erst enden, wenn die gesamte Branche jenes Produktionsvolumen erreicht hat, auf dem p0 den Marktpreis darstellt und somit sämtliche Extragewinne entfallen.[10] Die Preise p0 und p1 wiederum werden graphisch als Geraden dargestellt weil der jeweilige, für die gesamte Branche gültige Preis sich mit der Mengenvariation des Einzelunternehmens nicht ändert. Hätte das einzelne Unternehmen einen Einfluß auf den Marktpreis, müßten po und p1 monoton fallen, weil mit dem zusätzlichen Angebot des Unternehmens das Produktionsvolumen der gesamten Branche und damit der Marktpreis in Bewegung geraten würde. So aber wird unterstellt, dass „vollkommener Wettbewerb“ herrscht und die Unternehmen nur „Mengenanpasser“ sind, die erstens keinen Einfluß auf den Marktpreis nehmen können und zweitens entsprechend ihrer ertragsgesetzlichen Kostenstruktur bis zum „Betriebsoptimum“ produzieren, um dann ihre ebenfalls optimale Betriebsgröße erreicht zu haben. Dieses „interne Optimum“ ist allerdings an die ertragsgesetzliche Voraussetzung gebunden, dass alle Faktoren fix gegeben sind und nur ein Faktor variabel einsetzbar ist[11]. Würde dies anders gehandhabt und nur ein Faktor fixiert, während z.B. zwei andere Faktoren variieren, entstünde das Problem der exakten Ertragszuordnung zwischen den beiden variablen Faktoren. Auf die sich eigentlich in diesem Zusammenhang aufdrängende und in der einschlägigen Literatur weitgehend verweigerte – weil in neue Schwierigkeiten der neoklassischen Theorie führende – Debatte nach der „Faktor“Definition müssen wir an dieser Stelle verzichten[12]. § 4. Die Kritik Sraffas konzentrierte sich nun darauf, dass der uförmige Kostenverlauf nur unter sehr restriktiven und realitätsfernen Sonderbedingungen gilt, die für eine allgemeine Theorie inakzeptabel sind. So ist das Ertragsgesetz schon nicht mehr haltbar, wenn der „fixe Faktor“ teilbar ist, also zwar nicht vermehrt, aber vermindert, also in unterschiedlichen Dosen genutzt werden kann. Gerade im Bereich der Landwirtschaft besteht ja nicht der geringste Grund davon auszugehen, dass ein Landwirt immer seine gesamte Anbaufläche bebauen würde. Der australische Ökonom Steve Keen liefert in seinem Buch „Debunking Economics“ von 2007 ein sehr anschauliches Beispiel der Problematik.[13] Stellen wir uns vor, eine Farm verfügt über ein 100 Hektar großes Feld zum Weizenanbau. Das Feld liegt als „fixer Produktionsfaktor“ vor, welcher nicht vergrößert werden kann. Der „variable Produktionsfaktor“ sind die das Feld bearbeitenden Arbeiter.[14] Pro Hektar ist nun ein Arbeiter in der Lage, einen Scheffel Weizen zu produzieren. Zwei Arbeiter pro Hektar produzieren drei Scheffel, drei Arbeiter produzieren sechs Scheffel, vier Arbeiter produzieren zehn Scheffel und fünf Arbeiter produzieren zwölf Scheffel Weizen pro Hektar. Lassen wir nun das Ertragsgesetz mit einem variablen Produktionsfaktor (hier: die eingesetzten Arbeiter) gelten. Aus neoklassischer Sicht würde nun ein Farmer, der z.B. 100 Arbeiter anheuert, den „fixen Produktionsfaktor“ so nutzen, dass er die 100 Arbeiter auf die 100 Hektar verteilt und 100 Scheffel Weizen produziert. Nach Sraffa kann nun der Farmer entsprechend der ökonomischen Theorie sein Weizenfeld – den „fixen Faktor“ – nicht ausdehnen, er kann jedoch berücksichtigen, „dass der ‚konstante Faktor’ zwar nicht vermehrbar, aber durchaus verminderbar ist“[15]. Er wird dann 75 Prozent seiner Anbaufläche brachliegen lassen und seine 100 Arbeiter auf 25 Hektar arbeiten lassen mit dem Ergebnis, dass er nun 250 Scheffel Weizen erhält statt nur 100 Scheffel. Würde der Farmer 200 Arbeiter beschäftigen, käme er, würde er sich „streng nach Lehrbuch“ verhalten, auf 300 Scheffel Weizen und als „SraffaFarmer“ auf 500 Scheffel Weizen. Erst beim Einsatz von 400 Arbeitern würde sich automatisch eine „SraffaVerteilung“ der Arbeiter einstellen, weil der Farmer keinen Spielraum mehr hätte für brach liegende Kapazitäten; da nämlich der produktivste Einsatz von Arbeitern im Verhältnis zum Boden darin besteht, vier Arbeiter pro Hektar einzusetzen, ist bei 100 Hektar Anbaufläche erst beim Einsatz von 400 Arbeitern das optimale Einsatzverhältnis automatisch gegeben weil tatsächlich eine „Vollauslastung“ unvermeidlich wird. Bis zu diesem Punkt – Sraffa nennt ihn den „Punkt der maximalen Produktivität“ – gibt es allerdings gar kein „Ertragsgesetz“, sondern nur konstante Ertragszuwächse, denn der Farmer orientiert sich natürlich bei jedem Beschäftigungsgrad an der optimalen Verteilung von vier Arbeitern auf einen Hektar Anbaufläche. Abnehmende Erträge treten also erst auf, wenn mehr als 400 Arbeiter beschäftigt werden, denn dann ist die optimale Verteilung von Arbeitern zu Anbaufläche nicht mehr realisierbar und es muss begonnen werden, fünf Arbeiter pro Hektar einzusetzen. „Unter Gleichgewichtsbedingungen ist dieses Phänomen aber gänzlich uninteressant“[16], so der selbst der Neoklassik zuzurechnende österreichische Ökonom Oskar Morgenstern (19021977) in seiner ausführlichen Besprechung der Sraffaschen Kritik, „da die Produktion eben unmittelbar vorher“, nämlich an jenem Punkt der maximalen Produktivität, „abgebrochen wird“. Wir sind beim Einsatz der 400 Arbeiter nämlich am oben in der Besprechung von Grafik 2 erwähnten Schnittpunkt von Grenzkosten und Durchschnittskostenkurve, also im „Betriebsoptimum“. Das landwirtschaftliche Ertragsgesetz setzt somit zwingend voraus, dass Landwirte Ressourcen verschwenden, weil sie die optimale Faktorkombination verweigern und immer ihren „fixen Faktor“ hundertprozentig auslasten. In der Realität besteht allerdings nicht der geringste Anlaß, dass ein Landwirt derart irrational handeln und das ihm eigentlich unterstellte Prinzip der Gewinnmaximierung verlassen sollte, zumal die Teilung landwirtschaftlicher Flächen sehr viel einfacher zu bewerkstelligen ist als beispielsweise die Teilung einer Maschine in der Industrieproduktion. § 5. Das industrielle Ertragsgesetz als Fundierung der Angebotskurve erweist sich aber noch von einer anderen Seite her als „prekär“, denn es müssen sowohl die Unabhängigkeit der Angebots von der Nachfragekurve als auch die Unabhängigkeit der Angebotskurven verschiedener Anbieter innerhalb des gleichen Marktes gewährleistet werden. Stellen wir uns vor, dass Unternehmen einer Branche den „fixen Faktor“ untereinander tauschen, so könnten einige Unternehmen konstante Kostenverläufe erreichen. Das unternehmensinterne Ertragsgesetz wäre dann ausgesetzt, was wiederum Probleme bereiten würde in Bezug auf die Angebotskurve der Gesamtbranche. Genausowenig darf die von den Unternehmen der anbietenden Branche beeinflusste Verteilungssituation des „fixen Faktors“ Auswirkungen haben auf die Nachfragesituation jener Marktakteure, welche das Produkt der Anbieter nachfragen, denn sonst könnten durch Produktionsvariationen der Anbieter Rückkoppelungseffekte zwischen Angebot und Nachfrage entstehen, welche die Kurvenformen komplett verändern könnten. Anders gesagt, darf keine Interdependenz zwischen Anbietern und Nachfragern durch Produktionsvariationen der Anbieter (oder Nachfragevarianzen der Nachfrager) entstehen. Von den Neoklassikern muss deshalb letztlich eine ökonomische Modellsituation konstruiert werden, in welcher erstens alle Firmen einer Branche an eine fixe, unveränderliche Ausstattung mit dem knappen Faktor gebunden sind, und zweitens dieser Faktor nur in dieser speziellen Branche existiert und in keiner anderen. Punkt 1, der die Möglichkeit partiell abweichender Ertragsverläufe eliminieren soll, ist offenbar nicht vereinbar mit der Tatsache, dass alle Faktoren Waren sind und damit auch zwischen Unternehmen einer Branche getauscht werden können. Punkt 2, welcher die Rückkoppelung der Angebots mit der Nachfragekurve ausschalten soll, stellt ebenfalls eine sehr restriktive Voraussetzung dar, denn nur sehr wenige Produktionsmittel sind ausschließlich verwendbar in einer einzigen Branche. Im Prinzip werden hier also die (verteilungsrelevanten) Verflechtungsbeziehungen zwischen Unternehmen ausgeklammert, denn die neoklassische Theorie der Produktion ist generell gekennzeichnet von dem Bild „einer Einbahnstraße, die von den ‚Produktionsfaktoren’ zu den ‚Konsumgütern’ führt“[17], so Piero Sraffa. § 6. Eine letzte Chance hätte die neoklassische Theorie, wenn sie trotz der logischen Einwände Sraffas immerhin auf die große empirische Relevanz des „industriellen Ertragsgesetzes“ in der Wirklichkeit verweisen könnte. Aber auch von dieser Seite spricht alles für die Untauglichkeit der herrschenden Lehre. Es sei hier nur exemplarisch auf das klassische Lehrbuch „Grundlagen der Betriebswirtschaftslehre“ des „Begründers der modernen deutschen Betriebswirtschaftslehre“ (wikipedia), des Kölner Ökonomen Erich Gutenberg (18971984), verwiesen, das ein eigenes Kapitel „über empirische Kostenuntersuchungen“ enthält.[18] Gutenberg fasst die empirischen Forschungsergebnisse so zusammen:

Von sämtlichen empirischen Untersuchungen, die Gutenberg aufzählt, findet sich bezeichnenderweise keine einzige, welche eine nennenswerte Bedeutung des neoklassischen Kostenverlaufs in der Realität bestätigen kann.[20] Nachdem die Hypothese uförmiger Grenzkostenkurven also zum Zwecke der Wirklichkeitsbeschreibung so gut wie obsolet ist, wenden wir uns wie Sraffa der Frage sinkender Grenzkosten und damit einher gehender steigender Skalenerträge zu. 3. Fallende bzw. konstante Kosten § 7. Der in der modernen ökonomischen Theorie frühzeitig erkannte Erfahrungstatbestand fallender Kosten ist üblicherweise auf zwei Ursachen zurückzuführen. Die erste Ursache – sie geht im Ursprung auf Adam Smith zurück – liegt in der Möglichkeit, mit der Produktionsausweitung komplexere Tätigkeiten in einfache zu „zerlegen“ und somit durch eine verstärkte, spezialisierte Arbeitsteilung positive Kosteneffekte zu erzielen. Adam Smith demonstrierte dies als erster Ökonom an seinem berühmten Beispiel der durch Spezialisierung gesteigerten Effizient bei der StecknadelProduktion. Die zweite Ursache abnehmender Kosten leitet sich aus der Tatsache ab, dass jedes Unternehmen mit einer bestimmten Menge „fixer Kosten“ belastet ist, die mit der Ausweitung der Produktion sinken weil umgelegt auf eine höhere Stückzahl[21]. Für das Einzelunternehmen muss nun allerdings die Neoklassik den Fall firmenintern steigender Erträge ausschließen, denn „es ist einleuchtend, dass, wenn ein Betrieb seine Kosten durch Erhöhung der Produktion grenzenlos verringern kann, er fortwährend den Verkaufspreis reduzieren müsste, bis er den ganzen Markt erobert hat. Dann aber ist die Hypothese der Konkurrenz nicht mehr gültig“.[22] Genauso müssen aber auch branchenexterne Kostenersparnisse ausgeschlossen werden, denn sie sind wiederum nicht mit der Unabhängigkeit von Angebots und Nachfragekurven vereinbar. Was bleibt, um die Möglichkeit fallender Kosten „wenigstens aus formaler Sicht“[23] zu berücksichtigen ist der Fall firmenextern und branchenintern steigender Erträge. Hier verbessert sich also die Kostenstruktur für eine streng isolierte Industrie, und innerhalb dieser Industrie wird der Kostenvorteil proportional an alle Wettbewerbsunternehmen weitergegeben, so dass der brancheninterne Wettbewerb nicht „verzerrt“ wird und sich kein Monopol herausbilden kann.[24] Für Sraffa beschreibt dieses Konstrukt steigender Skalenerträge freilich „eine rein hypothetische und irreale Konstruktion“[25], „die man ganz selten antrifft“[26], wenn überhaupt. Wenn wir uns einmal das ganz realistische und einfache Beispiel einer Verbesserung der Infrastruktur des Transportsystems durch eine Ausweitung des Handels ansehen, dürfte laut der von der Neoklassik zugelassenen Art steigender Erträge das Transportwesen nur diese eine Ware und keine einzige andere transportieren, weil sonst industrieextern steigende Erträge vorlägen. Es ist aber unmittelbar einsichtig, dass der übergreifende Vorteil aller auf die Transportinfrastruktur angewiesenen Unternehmen die empirisch wie auch logisch gehaltvollere Hypothese darstellt. Die notwendigen Basiskonstrukte des neoklassischen Wettbewerbsmodells sowie der neoklassischen Angebotskurve engen den Raum für den Fall steigender Erträge somit auf den unwahrscheinlichsten und unplausibelsten Fall ein und schließen gerade die gängigsten und relevantesten Fälle aus. Der Frankfurter Ökonom Bertram Schefold[27] weist in diesem Kontext auf das Paradoxon hin, dass in die Konstruktion der uförmigen Kostenkurve zwei unterschiedliche Branchenbegriffe eingehen, denn für den Kurventeil der fallenden Kosten werden firmenextern und branchenintern alle Unternehmen zusammengefasst, welche das gleiche Produkt herstellen, während im Kurventeil der steigenden Kosten alle Firmen zu einem Sektor zusammengefasst werden, die einen fix gegebenen Bestand eines Produktionsfaktors einsetzen. Es ist offensichtlich, dass beide Definitionen der Branche nicht identisch sind und deshalb auch von dieser Seite her die Angebotskurve logisch hochgradig inkonsistent ist. § 8. Konstante Kostenfunktionen wiederum sind trotz ihrer hohen empirischen Bedeutung und ihrer von Sraffa aufgezeigten Plausibilität für die neoklassische Unternehmenstheorie ebenfalls inakzeptabel, auch wenn konstante Kostenkurven die oben erwähnten „Rückkoppelungseffekte“ ausschließen. Wie wir gesehen haben, stellt sich der Preis für das disponierende Einzelunternehmen nämlich als horizontale Gerade dar, und bei konstanten Kosten lägen folglich – graphisch betrachtet – mit der Angebots und der Preisgerade zwei Horizontalen vor, die sich entweder nie treffen oder (wenn sie in eins fallen) unendlich viele Schnittpunkte aufweisen. Damit besteht für das Einzelunternehmen keine rationale Entscheidungsgrundlage in Bezug auf die Produktionsmenge sowie die Betriebsgröße. Wie Sraffa ferner zeigt, werden durch konstante Erträge sämtliche PreisMengenEffekte ausgehebelt und in der Folge die neoklassische Symmetrie von Angebot und Nachfrage destruiert. Was bleibt, ist die praktisch ausschließlich technologische Preisbestimmung durch das Angebot, also der klassische Ansatz der Nationalökonomie[28]. Es bleibt also als vorläufige Zusammenfassung festzuhalten, dass Sraffas Kritik einerseits die Theorie des „vollkommenen Wettbewerbs“ und andererseits die an die üblichen Angebots und Nachfragekurven gebundene Preisbildungsregel unterminiert. Des Weiteren bleiben auch die Theorie der Grenzproduktivität und die neoklassische Theorie des Unternehmens beschädigt zurück.[29] 4. Die kapitaltheoretische Kontroverse § 9. Als Konsequenz aus seinen frühen Studien, welche die neoklassische Theorie von Angebot und Nachfrage grundlegend in Frage stellten, arbeitete Sraffa seit der zweiten Hälfte der zwanziger Jahre des 20. Jahrhunderts an einer widerspruchsfreien Reformulierung der klassischen, auf David Ricardo zurück gehenden ökonomischen Theorie. Bevor er aber sein Programm zu einem für ihn zufriedenstellenden Ende bringen konnte, widmete sich Sraffa äußerst akribisch über drei Jahrzehnte der Herausgabe der Gesammelten Werke Ricardos einschließlich bis dato unveröffentlichter Manuskripte und Briefe. Mit der Beendigung dieser vielfach gerühmten, meisterhaften Editionsleistung, kehrte er Ende der fünfziger Jahre zu seinen in den zwanziger Jahren abgebrochenen Studien zurück und beendete seine älteren Vorarbeiten. Im Jahre 1960 erschien dann Sraffas äußerst kompakt gehaltenes Hauptwerk „Warenproduktion mittels Waren“, das neben der im Titel angedeuteten klassischen Thematik den bezeichnenden Untertitel „Einleitung zu einer Kritik der ökonomischen Theorie“ trägt. § 10. Sraffa geht in seinem Buch der Frage nach, welches Preissystem in einem ökonomischen System miteinander verflochtener, voneinander abhängig produzierender Industrien umfassende Reproduktion ermöglicht[30]. Sein Ansatz ist also im Gegensatz zur Neoklassik ein reproduktionstheoretischer, wobei Sraffa wie Marx eine Durchschnittsprofitrate unterstellt – die allerdings nicht wie bei Marx auf das gesamte eingesetzte Kapital berechnet wird (Materialkosten plus Löhne), sondern nur auf die Materialkosten (marxistisch gesprochen das „konstante Kapital“). In Sraffas Algorithmus, der am einfachsten in der Matrizenschreibweise sich darstellen läßt[31], werden dann die verschiedenen Produktionssektoren dergestalt miteinander in Beziehung gesetzt, dass in jeder Zeile das jeweils produzierende Kapital[32] und jeder Spalte das auf die verschiedenen Kapitalien als Produktionsmittel verteilte Kapitalgut aufgeführt wird.[33] Das Produkt aus Zeile und Spalte ist jeweils identisch, so dass verbrauchte und produzierte Mengen – also Inputs (plus Mehrprodukt) und Outputs – nicht voneinander abweichen können. Die große Stärke an Sraffas Ansatz liegt nun darin, dass er dadurch, dass er ein InputOutputSystem zur Preisberechnung nutzt, sehr geeignet ist zur kritischen Durchleuchtung der neoklassischen Theorie, da diese Theorie in ihrer Preis und Verteilungslehre gerade diese Verflechtungs bzw. Kreislaufstruktur des Produktionsprozesses ausblendet.[34] Weil aber auch die Neoklassiker die marktförmige Arbeitsteilung voraussetzen, kann mittels des Sraffa’schen Modells untersucht werden, wie sich die neoklassischen Aussagen verhalten, wenn dieses Moment ausdrücklich berücksichtigt und nicht durch oftmals nicht thematisierte – weil hoch problematische – Konstruktionen eliminiert wird. Sraffas Modell eines markträumenden Gleichgewichtspreises teilt viele Grundannahmen der Neoklassik[35], weshalb seine Aussagen eine Reihe Einsichten auch in die Allgemeine Gleichgewichtstheorie der Neoklassik erlauben.[36] § 11. Sraffas Hauptwerk führte in den sechziger Jahren in die sog. „CambridgeCambridgeKontroverse“[37], deren eigentlicher Startschuss der gegen die Neoklassik gerichteter Aufsatz „The Production Function and the Theory of Capital“ von Sraffas CambridgeKollegin Joan Robinson aus dem Jahre 1953 war.[38] In diesem Text stellte Robinson die bis dahin erfolgreich verdrängte Frage, wie denn überhaupt „Kapitalmengen“ (und damit „Kapitalstöcke“) in der ökonomischen Theorie gemessen werden können:

Robinsons Ausgangsfrage war also schlicht jene nach der Messung des Kapitalstocks, welcher ja die Grundvoraussetzung ist, einen Produktionsprozess zu beschreiben, in welchem unterschiedliche Kapitalgüter in Kombination mit Arbeit in Endprodukte umgewandelt werden. Die Produktionsfunktion bildet hierbei das Verhältnis von verbrauchten Produktionsmitteln und Arbeitsstunden zum Produktionsergebnis ab. Im Gleichgewicht entspricht in diesem Modell das Grenzprodukt der Arbeit dem Lohnsatz und das Grenzprodukt des Kapitals dem Zinssatz. Als heterogene, physische Güter lassen sich die Produktionsmittel aber offensichtlich nicht addieren, denn der Gebrauchswert jedes konkreten Gegenstandes liefert keinen Maßstab für eine quantifizierbare Homogenität. Im Jahr 1962, als sich die im Folgenden geschilderte Kontroverse zuzuspitzen begann, schrieb Joan Robinson deshalb mit Blick auf die Neoklassik:

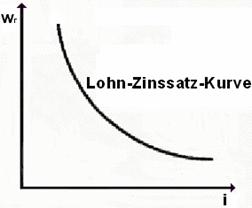

Was Joan Robinson kritisierte, war also die Erweiterung der physischen Grenzproduktivitäts bzw. Kapitaltheorie zu einer Theorie, welche mit „Kapitalmengen“ arbeitet und die Produktionsfunktionen konstruiert, in denen heterogene Kapitalgüter zu homogenen Einheiten zusammengefasst werden. Um nämlich das eigentlich physische Konzept der Grenzproduktivität zur Erklärung von Preisbildungsprozessen heranzuziehen, müsste der Formwechsel von der Gebrauchswert auf die Tauschwertebene plausibel vollzogen werden. Ansonsten wären Aussagen zum Sozialprodukt, zur personellen Einkommensverteilung und zur Wachstumstheorie nicht möglich. Darüber hinaus stand nun die Frage im Raum, wie denn der Kapitalwert gemessen werden könne unabhängig vom Zins, wie also der Zirkelschluss aus Kapitalwert und Zins vermieden werden könne. Joan Robinson schlug in ihrem Aufsatz von 1953 vor, die Kapitalgüter in Arbeitswerten zu messen, aber diese Lösung rehabilitierte einerseits ausgerechnet die von den Neoklassikern radikal abgelehnte Arbeitswertlehre und erwies sich andererseits als nicht unabhängig von der Verteilung durchführbar.[41] Von neoklassischer Seite gab es unterschiedliche Reaktionen auf Robinsons Herausforderung, im Wesentlichen aber drei „Lösungsversuche“ des Problems. Robert Solow[42] vom MIT untersuchte die theoretisch denkbaren Fälle, in welchen die Gesetze einer EinGutÖkonomie auf ein Wirtschaftssystem mit beliebig vielen Kapitalgütern übertragbar sind. Er erkannte, dass diese Spezialfälle durchweg keinen sinnvollen Lösungsansatz bieten, vertrat aber in dieser Phase der Debatte dennoch die – äußerst umstrittene – Meinung, dass „EinGutModelle“ eine gute Annäherung an die empirische Realität bilden. Der australische Ökonom und Wachstumstheoretiker Trevor Swan (1918 – 1989)[43] wiederum bestritt prinzipiell den logischen Gegensatz zwischen den physisch heterogenen Kapitalgütern und der für die neoklassische Kapitaltheorie üblichen Methode der Zusammenfassung dieser Güter zu einem einheitlichen „Kapitalwert“. Aus seiner Sicht handelte es sich hier um ein „Scheinproblem“, das nicht ökonomischmethodisch begründet sei, sondern auf sprachlichen Missverständnissen oder Ungenauigkeiten beruhe. Swan unterstellte zur Lösung des Problems den inhomogenen Kapitalgütern kurzerhand die Eigenschaft, zeit und kostenunabhängig ihre Gestalt wechseln zu können, so dass heterogene Kapitalgüter faktisch die Eigenschaften homogener Kapitalgüter aufweisen. Er sprach deshalb allen Ernstes von Kapital als „putty capital“ (dt. in etwa „SpachtelKapital“), was v.a. die HomogenitätsEigenschaft hervorheben sollte. Allerdings konnte sich dieses überaus kuriose Konstrukt auch unter neoklassischen Ökonomen nicht durchsetzen, denn es ist ganz offensichtlich nicht sinnvoll begründbar zu behaupten, dass sich eine Stanzmaschine kostenlos und ohne Zeitaufwand in eine Plexiglasscheibe verwandeln lässt oder der LKW eines Fuhrparks in das Kiefernholz einer Schreinerei. Joan Robinson hat diese seltsame, metaphysische „Kapital“Substanz entsprechend sarkastisch als „Ektoplasma“ denunziert und sich eher darüber Lustig gemacht als sie ernst zu nehmen.[44] Neben dieser äußerst fragwürdigen Methode zur Konstruktion seines „SpachtelKapitals“ kann aber auch Swans Lösungsversuch dem Zirkel der Kapitalwertbestimmung unabhängig von der Profitrate nicht entkommen, wie beispielsweise Harcourt und Laing zeigen.[45] Der englische Ökonom David Champernowne (19122000) versuchte in seinem Beitrag das Problem zu lösen mittels eines sog. „Kettenindexes des Kapitals“. Die Grundidee bestand darin, alle zur Verfügung stehendem Produktionstechniken in einer Rangfolge anzuordnen, bei der jeweils zwei benachbarte Techniken bei einem Zinssatz profitabel sind und keine dritte Technik relevant wird. Die Punkte der Technikwechsel liegen dann so verteilt, dass die verbundenen SwitchPunkte eine konvexe LohnZinssatzKurve ergeben, welche mit sinkendem Zinssatz eine höhere Kapitalintensität ausdrückt. Champernownes „Kettenindex“ konnte der Kritik aber ebenfalls nicht standhalten, denn erstens muss er den Zinssatz als exogen vorgegeben einführen – was dem neoklassischen Grundanspruch, Zins und Lohn modellintern zu bestimmen widerspricht – und zweitens kann sein Anordnungssystem reale WicksellEffekte wie auch PreisWicksellEffekte[46] prinzipiell nicht ausschließen.[47] Wie wir sehen können, hat die Debatte der fünfziger Jahre also keineswegs zu einer für die neoklassische Ökonomie und ihre Kritiker tragbaren Lösung des von Joan Robinson angesprochenen Problems der Kapitaltheorie geführt. §12. Als sich gerade Ende der fünfziger Jahre die Debatte wieder verlief, brachte Sraffas o.g. Publikation „Warenproduktion mittels Waren“ aufgrund ihrer analytischen Klarheit und Strenge die Wende in dieser nationalökonomischen Kontroverse. Im weiteren Verlauf der Debatte ab 1960 kritisierten die an Sraffa orientierten Ökonomen des britischen Cambridge[48] die neoklassische Wirtschaftstheorie scharf. Deren Hauptverteidiger kamen wiederum hauptsächlich vom MIT aus Cambridge/Massachusetts (USA), allen voran Paul Samuelson (19152009), sein Mitarbeiter David Levhari und der Wachstumstheoretiker Robert Solow. Gegenstand dieser Kontroverse war der bereits von Robinson angegriffene Erklärungszirkel, dass der Wert einer Kapitalmenge „knappheitstheoretisch“ über sein zinsförmiges Grenzprodukt bestimmt werden sollte, während zur Bestimmung des Zinses wiederum die Kapitalmenge fest definiert und bewertet sein muss. Anders gesagt, können im neoklassischen Gleichgewichtsmodell Preise und Verteilung nicht getrennt voneinander (die eine Größe auf der anderen kausal aufbauend), sondern nur simultan gemessen werden. Der Kapitalstock kann ferner – wie ursprünglich von den Neoklassikern beabsichtigt – nicht physisch gemessen werden, weil physisch heterogene Kapitalgüter sich nicht addieren lassen zu einem einheitlichen Kapitalstock. Der „Produktionsfaktor Kapital“ muss letztlich wertförmig gemessen werden, was eben das Bewertungsproblem aufwirft, dass Faktorpreise einerseits nicht auf physische Größen zurückgeführt werden können[49] und andererseits die Kenntnis bestehender Preise eine bereits gemessene Verteilung voraussetzt. Ferner ändern sich mit dem Preis eines Produktionsmittels auch die Preise der Produkte, in die dieses Produktionsmittel eingeht, was wiederum – bei wechselseitiger Verflechtung – Auswirkungen haben kann auf den ursprünglichen Preis des Produktes selbst etc. Eine „Einbahnstraßen“Theorie bzw. eine „EinGutTheorie“, welche nur ein Kapitalgut berücksichtigt, um das Aggregationsproblem zu umgehen, muss folglich versagen in einem vernetzten ökonomischen System wechselseitig sich konstituierender Größen und beliebig vieler Kapitalgüter. Ein guter Teil der Debatte drehte sich entsprechend um die Frage, welche Voraussetzungen getroffen werden müssen, damit EinGutModelle als sinnvolle Repräsentanz von Modellen mit beliebig vielen Kapitalgütern postuliert werden können. Die zentralen Probleme der Neoklassiker liegen hierbei einerseits darin, dem o.g. Zirkelschluss zu entgehen und eine Messung des Kapitalstocks unabhängig vom Zinssatz zu ermöglichen, sowie andererseits Effekte auszuschließen, welche die neoklassische Verlaufsform des Verhältnisses von Zinssatz und Lohnsatz zerstören. Die neoklassische LohnZinsKurve wird dargestellt in Grafik 3:

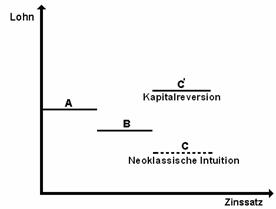

Grafik 3 Wie wir sehen, verhalten sich Lohnsatz und Zinssatz gegenläufig: sinkt der Lohnsatz wr, dann steigt der Zinssatz i und umgekehrt. Es handelt sich hier um eine sog. „substitutionale Produktionsfunktion“, da im Produktionsprozeß Faktorvariationen möglich sind und sich – im vereinfachten ZweiFaktorenModel – auch bei Konstanz eines Faktors das Produktionsergebnis (mit allerdings abnehmenden Zuwachsraten) erhöht.[50] Die Grenzproduktivität des Kapitals (der Arbeit) wiederum sinkt mit zunehmendem Kapitaleinsatz (Arbeitseinsatz). Anders gesagt stellen die Grenzproduktivitäten von Kapital und Arbeit nichts anderes als Knappheitsindices der Produktionsfaktoren Kapital und Arbeit dar: Je knapper ein Faktor im Produktionsprozess eingesetzt wird, desto höher sein Grenzprodukt und desto höher der Preis des Faktors. Folglich – und dies wiederum ist eine zentrale Kernaussage der neoklassischen Arbeitsmarkttheorie – führt ein Anstieg des Lohnsatzes dazu, dass Arbeit durch Kapital ersetzt wird und umgekehrt bei sinkenden Löhnen arbeitsintensiver produziert wird. § 13. Dieses Theorem eines streng determinierten Zusammenhangs zwischen Zinsniveau und Kapitalintensität der Produktion ist nun in einer Welt interindustrieller Verflechtung und beliebig vieler Kapitalgüter nicht mehr sinnvoll begründbar. Neben Keynes’ Theorie der „effektiven Nachfrage“ – welche vom Doppelcharakter betriebwirtschaftlicher Arbeitskosten als gleichzeitigem Element zahlungskräftiger Nachfrage ausgeht – erfährt die neoklassische LohnZinsTheorie hier eine zweite, rein von der Produktionsseite ausgehende Kritik. Neben das bereits erwähnte Problem der verteilungsunabhängigen Messung des Kapitalstocks gesellen sich zwei Phänomene, die der Schwedische Neoklassiker Knut Wicksell (18591926) bereits zu Beginn des 20. Jahrhunderts entdeckt hat. Das erste Phänomen ist der sog. „PreisWicksellEffekt“ welcher darin besteht, dass ein steigendes Zinsniveau (fallendes Lohnniveau) durchaus mit steigender Kapitalintensität einher gehen kann. Erst Sraffa und seine Schüler haben aber diesen Effekt klar analytisch verstanden, denn bei unterschiedlich kapitalintensiven Branchen löst ein Wechsel des Lohn bzw. Zinsniveaus miteinander in Wechselwirkung stehende Preisfluktuationen aus, die bei unterschiedlich kapitalintensiv produzierten Gütern zu einem gänzlich neuen Gleichgewichtszustand führen. Eine fest determinierte Richtung, wie die Neoklassiker aufgrund ihrer illegitimen EinGutModelle annehmen, muss dieser Prozeß aber keineswegs nehmen. Dieses Phänomen wurde in der neueren Literatur dann „Kapitalreversion“ („reverse capital deepening“) genannt. Wir können einen solchen Effekt der „Kapitalreversion“ in Grafik 4 betrachten:

Mit steigendem Zinssatz müßte aufgrund der Logik der neoklassischen Parabeln folgen, dass der Lohnsatz kontinuierlich fällt. Die „neoklassische Intuition“ würde also beispielsweise von der gestrichelten Position C ausgehen. Bei Kapitalreversion tritt aber Position C’ auf, bei welcher, wie wir sehen, das Lohnniveau trotz steigenden Zinssatzes höher liegt als die Lohnniveaus A und B. Des Weiteren hat Wicksell aber auch mit der Neoklassik nicht vereinbare „Anomalien“ in Bezug auf mögliche – beim „PreisWicksellEffekt“ noch ausgeschlossene – Technikwechsel verortet, die sog. „realen WicksellEffekte“. Bei jenen tritt eine mit einer bestimmten Kapitalintensität assoziierte Technik bei einem hohen Zinsniveau auf, wird dann von einer anderen Technik abgelöst, und kehrt schließlich zurück auf einem niedrigeren Zinsniveau. Man spricht deshalb hier auch von einer „Wiederkehr der Technik“ („Reswitching“). Aus neoklassischer Sicht kann eine kapitalintensivere Technik aber nicht auf einem niedrigeren Niveau des Lohnsatzes – bzw. einem höheren Niveau des Zinssatzes – „zurückkehren“, da mit fallenden Löhnen die Unternehmen beständig auf lohnintensivere Techniken ausweichen. Wird dieser deterministische Zusammenhang aufgegeben, ist die neoklassische Verteilungstheorie – und damit die Preistheorie – nicht mehr haltbar, denn ein knapper werdender Produktionsfaktor kann nun im Preis fallen und ein weniger knapper im Preis steigen. In der Folge erweist sich auch die neoklassische Arbeitsmarkttheorie als unhaltbar, denn die dort vorausgesetzte Arbeitsnachfragekurve ist mit „Reswitching“ (wie auch mit „Kapitalreversion“) nicht vereinbar.[51] Mittels relativ einfacher Zahlenbeispiele in einem ZweiSektorenModell läßt sich das ReswitchingPhänomen – das von Neoklassikern gern wortgewaltig als „pervers“ (weil mit ihren Modellen inkompatibel) bezeichnet wurde – aufzeigen.[52] Eine graphische Darstellung eines Effektes der „Wiederkehr der Technik“ finden wir Grafik 5:

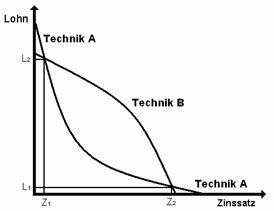

Grafik 5 Wir sehen hier zwei Technikkurven – Technik A, welche eine konvexe Verlaufsform einnimmt, und Technik B, welche konkav verläuft – sowie die beiden Schnittpunkte L1/Z2 und L2/Z1. Technik A ist kostenminimierend oberhalb des Lohnsatzes L2 (bzw. unterhalb des Zinssatzes Z1) sowie unterhalb des Lohnsatzes L1 (bzw. oberhalb des Zinssatzes Z2). Zwischen diesen „Switchpunkten“ fällt die Wahl profitmaximierender Kapitalisten auf Technik B. Aus neoklassischer Sicht kann eine kapitalintensivere Technik freilich nicht auf einem niedrigeren Niveau des Lohnsatzes „zurückkehren“, da mit fallenden Löhnen die Unternehmen beständig auf lohnintensivere Techniken ausweichen. Versuche neoklassischer Ökonomen, diese Paradoxa in den Griff zu bekommen, scheiterten auf ganzer Linie.[53] Paul Samuelson als einer der führenden Vertreter der neoklassischen Mikroökonomie konstruierte z.B. im Jahre 1962 eine sog. „SurrogatProduktionsfunktion“, mittels derer er das Problem in den Griff bekommen wollte. Er selbst zog dieses Konstrukt allerdings nach kurzer Zeit wieder zurück, nachdem seine implizite Modellannahme gleicher Kapitalintensität in allen Branchen von Sraffas Schülern aufgedeckt wurde – was natürlich im Endeffekt darauf hinauslief, dass es sich hier auch nur um eine Spielart einer „EinGutÖkonomie“ handelt, welche doch gerade überwunden werden sollte. Ein zweiter Gegenschlag kam dann im Jahre 1965 von Samuelsons Mitarbeiter David Levhari, der beweisen zu können glaubte, dass die Möglichkeit einer „Wiederkehr der Technik“ theoretisch widerlegt werden könnte mittels eines komplizierten Modells linearer Optimierung. Beweisziel dieses Verfahrens war es nachzuweisen, dass eine „Wiederkehr der Technik“ nur einzelwirtschaftlich auf der Unternehmensebene auftreten könne, gesamtwirtschaftlich allerdings keinen Effekt hätte, also irrelevant sei auf der Makroebene. Wie Luigi Pasinetti aber bereits wenige Monate später auf dem „First World Congress of the Economic Society“ in Rom zweifelsfrei beweisen konnte, beruhte dieses SamuelsonLevhariTheorem auf mathematischen Fehlern, was beide auch unumwunden in einem schmachvollen Text mit dem Titel „The NonswitchingTheorem is false“ im Jahre 1966 eingestanden. Die neoklassische Theorie war damit eigentlich weitgehend erledigt und dies wurde von dem zentralen Verteidiger der neoklassischen Produktions und Verteilungstheorie, Paul Samuelson, auf einem kapitaltheoretischen AbschlußSymposium des „Quarterly Journal of Economics“ (wo ein guter Teil der gesamten Kontroverse ausgetragen wurde) im Jahre 1966 in aller Offenheit eingeräumt.[54] Einen von Samuelson gesonderten Verteidigungsversuch unternahm noch der MITWachstumstheoretiker Robert Solow, indem er von der Bestandsgröße „Kapital“ auf die Stromgröße „Investition“ auszuweichen versuchte. Solows zunächst genial anmutender Gedankengang war der, dass die „gesellschaftliche Ertragsrate einer Investition“ – also die Ermöglichung zukünftigen Konsums durch heute Sparentscheidungen (die gleichbedeutend ist mit Konsumverzicht) – geeignet sei, den Zinssatz indirekt zu bestimmen und damit der Zirkelproblematik zu entkommen. Diese Ertragsrate sollte deshalb unabhängig vom Kapitalstock – in einer „Kapitaltheorie ohne Kapital“, wie das die Neoricardianer etwas sarkastisch formulierten – gemessen werden können als physische Größe. Solows theoretischen Arbeiten dieser Zeit konzentrierten sich also auf die Erbringung des Nachweises der Identität beider Größen. Wie sich allerdings im Verlauf der Debatte herausstellte, musste Solow, um diese Identität festzulegen, äußerst problematische Voraussetzungen in sein Modell einbauen, die den Rettungsversuch selber zum hoffnungslosen Problemfall machten. Der Kieler Wirtschaftwissenschaftler Harald Hagemann hat in seiner mehrfach ausgezeichneten Promotionsarbeit zu Solows Theorem dessen gravierende Defizite minuziös ausgearbeitet und hierbei eine sehr viel detailliertere Kritik formuliert als Solows Kritiker Joan Robinson und Luigi Pasinetti.[55] Im Verlauf der Diskussion konnte ferner aufgezeigt werden, dass die Verteilungsabhängigkeit der Kapitalgüter im neoklassischen StandardModell bei Solow als Verteilungsabhängigkeit der Investitionsgüter zurückkehrt. Solow selbst hat aufgrund der sehr stichhaltigen Kritik schließlich im Verlauf der siebziger Jahre seinen Erklärungsanspruch weitgehend zurückgezogen.[56] In Folge dieser Niederlagen traten eine Reihe von Neoklassikern den Rückzug auf die Allgemeine Gleichgewichtstheorie in ihrer kurzfristigen Gestalt mit heterogenen Eigenzinssätzen an.[57] So kann die leidige KapitalProblematik durch ein komplett disaggregiertes, mikroökonomisches Modell umgangen werden, allerdings um den Preis einer Verabschiedung von makroökonomischen Fragestellungen, die immer Aggregationsprobleme implizieren. Dazu muss angemerkt werden, dass einerseits Effekte der „Wiederkehr der Technik“ auch in Modellen des allgemeinen Gleichgewichts auftreten können[58] und andererseits diese Modelle daran kranken, dass sie ihren eigenen Anspruch systematisch verfehlen. Neben den bekannten schweren Defiziten der Allgemeinen Gleichgewichtstheorie – der Unmöglichkeit, das Geld gleichgewichtstheoretisch zu integrieren, der widersinnigen Koordination des eigentlich dezentral gedachten Marktes durch einen zentralen „Auktionator“ und des kompletten Verschwindens der Unsicherheit, indem die komplette Zukunft in Gegenwartskontrakten vorweggenommen wird – haben mathematisch versierte Fachwissenschaftler wie Herbert Scarf, Donald Saari und Hugo Sonnenschein seit den siebziger Jahren diesem äußerst abstrusen Gebilde längst den letzten Sargnagel verpasst.[59] Das grundlegende Problem wurde darin identifiziert, dass allgemeine Gleichgewichte trotz aller heroischen Abstraktionsannahmen prinzipiell instabil und nicht eindeutig sind, was dem immanenten Beweisziel der Theorie strikt entgegengesetzt ist und ihr logisches Fundament komplett untergräbt.[60] Mit dem Verweis auf die Allgemeine Gleichgewichtstheorie, dies können wir als Resümee also festhalten, wurde keineswegs eine Art „eleganter Lösung“ gefunden, sondern im Gegenteil die Flucht von einem untergehenden Schiff auf einen sinkenden Dampfer angetreten. § 14. Als wichtigste Ergebnisse der kapitaltheoretischen Debatte wollen wir also festhalten, dass einerseits die neoklassische Verteilungslehre resp. die Theorie der „Knappheitspreise“ und andererseits die neoklassische Theorie des Arbeitsmarktes schwer beschädigt sind.[61] Die neoklassische Arbeitsmarkttheorie kollabiert, weil aus einer Veränderung des Lohnniveaus nach unten kein höheres Beschäftigungsniveau folgen muss – und vice versa –, da sich mit der Lohnänderung Faktorpreise ändern und diese bei unterschiedlich kapitalintensiven Branchen zu neuen Preisen sowie möglichen Technikwechseln führen, deren Tendenz keineswegs dem neoklassischen EinbahnstraßenDeterminismus (ein niedrigeres Lohnniveau führt automatisch zu mehr Beschäftigung und umgekehrt) folgen muss. Die neoklassische Arbeitsmarkttheorie mit ihrer monoton fallenden ArbeitsnachfrageKurve (die Unternehmen fragen mit abnehmendem (zunehmendem) Lohnsatz mehr (weniger) Arbeit nach) ist demnach unhaltbar, weil durch die Möglichkeiten von Kapitalreversion und „Wiederkehr der Technik“ zerstört. Die von den Vertretern der Neoklassik nach einigen gescheiterten Immunisierungsversuchen eingeräumte Stichhaltigkeit der Kritik wird aufgrund ihrer Brisanz bis heute weitgehend ignoriert und der längst widerlegte theoretische Hintergrund gängiger ArbeitsmarktEmpfehlungen standhaft angewendet und vorausgesetzt.[62] 5. Der vollkommene Wettbewerb § 15. Sraffas Kritik an der Neoklassik betraf neben der Kritik des industriellen Ertragsgesetzes, wie bereits erwähnt, einen sehr wichtigen und heute wieder aktuellen und international diskutierten Punkt. Wie gesehen, geht die neoklassische Unternehmenstheorie von einem „vollkommenen Wettbewerb“ zwischen den Anbietern aus mit dem Effekt, dass der Preis einer bestimmten, unter Konkurrenzbedingungen produzierten Ware für jedes Einzelunternehmen ein „äußeres Datum“ darstellt, welchen es durch seine eigene auf den Markt geworfene Produktionsmenge nicht beeinflussen kann. Sraffa war mit dieser Theorie nicht zufrieden, denn sie setzt voraus, dass (a) alle Güter homogen, also sachlich gleichartig sind, (b) keine persönlichen Präferenzen bestehen bei der Auswahl des Anbieters (es zählt also nur die Höhe des Preises), (c) zeitliche Präferenzen bei Käufer oder Verkäufer ausgeschlossen werden, (d) räumliche Präferenzen bei Käufern und Verkäufern ebenfalls nicht existieren sowie (e) der Markt absolut transparent ist und alle Marktsubjekte vollständig informiert sind.[63] In seinem kritischen Resümee zur neoklassischen Wettbewerbstheorie führt Sraffa schließlich die beiden zentralen Prämissen an, von denen sie sich aufgrund ihrer Unhaltbarkeit definitiv verabschieden muss. Er nennt

Letztlich führten diese Erkenntnisse bei Sraffa zu einer ersten, ein zukünftig zu realisierendes Forschungsprogramm kurz umreißenden Diskussion jener Wettbewerbsformen, die nur wenige Jahre nach seiner Kritik (in den Jahren 1933 und 1934) unabhängig voneinander unter dem Stichwort des „monopolistischen Wettbewerbs“ von Joan Robinson, Edward Chamberlin (18991967) und Heinrich von Stackelberg (19051946) ausgearbeitet wurden.[65] In diesem Zusammenhang kritisiert Sraffa die für die Idee des „vollkommenen Wettbewerbs“ notwendige Annahme „der Indifferenz der Käufer gegenüber den Produzenten“[66] bzw. der vollkommenen Substituierbarkeit und Homogenität der Güter einer Branche. Einerseits sind nämlich Käufer durch die verschiedensten Gründe keineswegs indifferent gegenüber den Unternehmen – Sraffa nennt als Beispiele lange Gewohnheiten, persönliche Bekanntschaften, Vertrauen auf die Qualität der Ware, die Nähe der Firma usw.[67] Andererseits sind Produkte, wie aus der Werbung hinreichend bekannt ist, sehr oft direkt mit dem Namen des Produzenten verbunden und von daher prinzipiell nicht (durch Produkte eines anderen Produzenten) substituierbar – man denke nur als einfaches Beispiel an den Markt für Sportschuhe und die jeweiligen Produkte „NikeSchuhe“ oder „AdidasSchuhe“ etc. Wirklich gleichartig wären nur Produkte von ein und demselben Produzenten, womit aber die Wettbewerbssituation selbst negiert wäre. Sraffa sieht in dieser engen Verbindung von Produkt und produzierendem Unternehmen eine die angenommene Indifferenz des Käufers weitgehend negierende „privilegierte Stellung“ des Einzelunternehmens bzw. seines Produktes. Diese Vorteile der spezifischen MarkenProduktzuordnung sind „denen ähnlich, derer sich der gewöhnliche Monopolist erfreut“[68]. Der Markt für Sportschuhe, um in unserem Beispiel zu bleiben, bleibt also segmentiert in zahlreiche Einzelmärkte, auf denen es jeweils kleinere Monopolstellungen gibt, die sich über die Art und Weise konstituieren, wie die jeweiligen Käufer das Produkt als Produkt (mit einem bestimmten „Markenimage“) different bewerten. § 16. Eine gewaltige Aufwertung haben Sraffas Studien aus den zwanziger Jahren in jüngster Zeit erfahren, da der Nachweis erbracht werden konnte, dass die formalmathematischen Aussagen, welche dem Modell des „vollkommenen Wettbewerbs“ zugrunde liegen, logisch inkonsistent aufgebaut sind. Der zentrale Punkt dieser Debatte liegt in Sraffas erstem Argument gegen die neoklassische Wettbewerbstheorie, in der Kritik der Annahme eines reinen „Mengenanpasser“Verhaltens ohne Preissetzungsmacht. Den logischen Beweis dieser – von Sraffa in den zwanziger Jahren eher beiläufig erwähnten – These hat der australische Ökonom Steve Keen von der Universität Western Sydney international bekannt gemacht.[69] In Deutschland wurde Keens Kritik dann von dem Remagener Wirtschaftsmathematiker Jürgen Kremer in mehreren Publikationen bestätigt[70]. Dieser Beweis hätte Sraffa vermutlich nicht überrascht, denn die Annahme, dass ein einzelnes Unternehmen prinzipiell keinen Einfluß auf die Preisbildung der von ihm vertriebenen Produkte nehmen kann (also nicht mal einen minimalen), erscheint äußerst unplausibel. Steve Keen vergleicht diese neoklassische Einstellung mit der Auffassung, dass die Erde nicht rund sei weil das Stück Boden auf dem eine Person steht, ja offenbar flach ist und womöglich auch sein Parkplatz vor dem Haus oder sein Garten im Prinzip flach verlaufen.[71] Diese Annahmen sind natürlich näherungsweise richtig und logisch, aber sobald daraus die übergeordnete Theorie einer flachen Welt folgt, ist diese Theorie falsch. Wenn schon eine systematische Verarbeitung von Wirklichkeitsphänomenen mittels schrittweiser Abstraktion betrieben wird um ein generelles Modell zu entwerfen, müsste sinnvollerweise unterstellt werden, dass jedes Teilstück auf dem Weg zur Weltumrundung – trotz Bergen, Tälern etc. – über die gleiche Krümmung verfügt, so dass im theoretischen Ergebnis wie in der Wirklichkeit die Welt rund (und nicht flach) ist. Es geht hier also nicht darum, die üblichen Abweichungen der Realität vom auf mehreren Abstraktionsebenen konstruierten Modell zu kritisieren – diese Auffassung würde letztlich jede theoretische Arbeit mit von Teilaspekten der Wirklichkeit abstrahierenden Modellen verbieten und wäre deshalb sinnlos –, sondern aufzuzeigen, dass mit der horizontalen Preisgeraden in der Unternehmenstheorie ein prinzipieller Denkfehler vorliegt, der eben im übertragenen Sinne rein logisch zu einer flachen (statt runden) Welt führt und deshalb nicht akzeptabel ist. Der mathematische Ableitungsfehler im neoklassischen Formelapparat wurde allerdings nicht erstmalig von Steve Keen persönlich entdeckt, sondern bereits im Jahre 1957 von dem selbst neoklassisch ausgerichteten USÖkonomen und Nobelpreisträger George Stigler (19111991). Dessen Hinweis – versteckt allerdings in einer eher unauffälligen Fußnote[72] – wurde nun, obwohl veröffentlicht in einem Aufsatz in der angesehenen Chicagoer Fachzeitschrift „Journal of Political Economy“, pikanterweise rund 40 Jahre lang nicht zur Kenntnis genommen, auch nicht nach der Veröffentlichung einer Übersetzung seines Aufsatzes im Jahr 1975 in Deutschland in einer Aufsatzsammlung zur Wettbewerbstheorie. Stigler selbst sah das von ihm aufgeworfene Problem und versuchte es zu umgehen, indem er die Zahl der Unternehmen in einem Sektor gegen unendlich gehen lassen wollte, was praktisch unendlich kleine Unternehmen impliziert[73]. Diese Annahme ist freilich wenig überzeugend und auch schon deshalb nicht haltbar, weil die bereits erläuterte uförmige Kostenkurve ja nicht nur dem Unternehmensmaximum, sondern auch dem Unternehmensminimum eine Grenze setzt. Ferner ist diese Lösung aber auch deshalb logisch problematisch, weil die Größe der Unternehmen, auch wenn sie „gegen Null geht“, nicht Null beträgt und deshalb wiederum marginale Einflüsse der Mengenvariationen einzelner Kleinstfirmen auf den Gesamtoutput bestehen blieben. Da die Nachfragekurve mit zunehmender Menge sinkt, muss dieser Zusammenhang ganz unabhängig von der Größe resp. Anzahl der Firmen und somit dem Monopolisierungsgrad der Branche gelten[74]. Es ist insofern unmittelbar einsichtig, dass auch Steve Keen zu dem Fazit kommt, dass „jede Branche zur Monopollösung tendiert, unabhängig von der Anzahl der Unternehmen“[75], denn es existiert keine logisch konsistente Begründung der horizontalen Nachfragekurve. Die Preisbildungsregel eines Monopolisten unterscheidet sich von der eines Unternehmens im „vollkommenen Wettbewerb“ nun dadurch, dass der Monopolist – wie gesehen – bei Ausweitung seiner Produktionsmenge mit einer fallenden – statt horizontalen – Preiskurve konfrontiert ist und deshalb seine Grenzerlöskurve unter der Nachfragekurve liegt, denn die Grenzerlöse betreffen nur die Erlöse der letzten produzierten Einheit, während die Nachfragekurve auch für alle vorher produzierten Einheiten gilt (und somit mit der Durchschnittserlöskurve zusammenfällt).[76] Wenn der Monopolist also die (auch für ihn geltende) neoklassische Preisbildungsregel anwendet und den Preis im Schnittpunkt von Grenzkosten und Grenzerlöskurve festlegt, bildet sich ein Raum zur Nachfragegeraden, der den Extragewinn des Monopolisten (und damit den Wohlfahrtsverlust der Konsumenten) markiert. Eine graphische Darstellung dieses Zusammenhangs bietet Grafik 6:

Grafik 6 Hier sehen wir, wie die Grenzerlöskurve unterhalb der Nachfragekurve (= Durchschnittserlöskurve) verläuft und im sog. „Cournot’schen Punkt“ – benannt nach dem französischen Wirtschaftswissenschaftler Antoine Augustin Cournot (18011877) – von der Grenzkostenkurve geschnitten wird. Im Punkt M1/P1 befindet sich folglich der Monopolpreis, der bei geringerer Produktionsmenge und einem höheren Preisniveau liegt als der Wettbewerbspreis M2/P2. Der Wohlfahrtsverlust durch diese Verschiebung wird sichtbar in der grauen Dreiecksfläche zwischen der Grenzkosten und der Nachfragekurve, denn der Monopolist produziert mit M1 unterhalb der gesellschaftlich effizienten Menge M2. Bei der Mengenentscheidung M1 wiederum liegt der Preis oberhalb der Grenzerlöskurve, was bedeutet, dass jene Konsumenten, welche innerhalb der grauen Fläche kaufen würden nicht zum Zug kommen, weil dieser Spielraum einseitig vom Monopolisten ausgeschöpft wird. Wie leicht zu erkennen ist, hat die veränderte Situation der monoton fallenden Nachfragekurve also drastische Konsequenzen für die Wohlfahrt des ökonomischen Systems. Über eine Angebotskurve nach gängigem AngebotsNachfrageSchema verfügt ein Monopolist nicht, da er seine Mengenentscheidung nicht nach einem gegebenen Preis richtet, sondern er diesen Preis selber beeinflussen kann durch sein Produktionsvolumen. Es macht deshalb, so Gregory Mankiw und Mark Taylor in ihrem neoklassischen Standardlehrbuch zur Volkswirtschaftslehre, „keinen Sinn danach zu fragen, welche Menge ein Monopol bei einem bestimmten Preis anbieten würde, da der Monopolist den Preis in dem Augenblick festsetzt, in dem er auch seine Angebotsmenge wählt“.[77] Für einen Monopolisten ist vielmehr „die Angebotsentscheidung (…) untrennbar mit der Nachfragekurve verknüpft, der er sich gegenübersieht. Der Verlauf der Nachfragekurve definiert die Gestalt der Grenzerlöskurve, die ihrerseits die gewinnmaximierende Ausbringungsmenge des Monopolisten bestimmt“.[78] Die in § 5 erörterte Kritik Sraffas am Theorem der Unabhängigkeit von Angebot und Nachfrage wird im Zuge des Zusammenbruchs der horizontalen Nachfragekurve somit letztlich gestärkt durch die korrigierte Wettbewerbs und Unternehmenstheorie. Das Erklärungsprinzip von „Angebot und Nachfrage“ im theoretischen Rahmen der Neoklassik sieht sich folglich durch die neuere, hier wiedergegebene Kritik der Standardlehre zur Unternehmenstheorie mit einer weiteren, immanenten Widerlegung konfrontiert. § 17. Zusammengefasst kann als logische Folge des mathematischen Fehlers in der Theorie des „vollkommenen Wettbewerbs“ konstatiert werden, dass dieser Wettbewerb überaus unvollkommen ist. Graphisch illustriert stellt sich dies so dar:

Grafik 7 Wir sehen, dass nun die Steigung der GesamtNachfragekurve P/M identisch ist mit dem Kurvenabschnitt pi/mi, mit der ein willkürlich ausgewähltes Einzelunternehmen konfrontiert ist. Hier wird nun im Prinzip der – eigentlich nicht gerade überraschenden – Tatsache Rechnung getragen, dass eine monoton fallende Gerade selbst in ihren kleinsten Einzelabschnitten monoton fällt bzw. umgekehrt, dass auch beliebig viel addierte horizontale Geraden keine monoton fallende Gerade ergeben würden.[79] Mit dieser Korrektur der im neoklassischen Modell auftretenden Fehler läßt sich auch die neoklassische Regel der unternehmerischen Profitmaximierung, die ja davon ausgeht, dass Grenzkosten und Marktpreis identisch sind im Gewinnmaximum, nicht länger halten. Vielmehr kann der Marktpreis – wie in Grafik 6 dargestellt – dauerhaft über den Grenzkosten liegen und somit können Märkte unterhalb des von der Neoklassik selbst propagierten WohlfahrtsOptimums arbeiten. Diese Wohlfahrtsverluste wiederum können nicht einer wettbewerbsfremden Monopolkonstellation zugeschrieben werden, sondern wurzeln im profitmaximierenden Verhalten der Unternehmen selbst. Nach der Korrektur ihrer formalen Fehler bleibt von der herrschenden, neoklassischen Wirtschaftstheorie, wie wir sie kennen und wie sie in den entsprechenden StandardLehrbüchern gelehrt wird, praktisch nichts übrig. Die einzig noch denkbare, rationale Verteidigungsstrategie neoklassischer Ökonomen könnte darin bestehen, den „vollkommenen Wettbewerb“ mittels spieltheoretischer Modelle strategischer Interaktion der Wettbewerber zu retten. Jürgen Kremer prüft diese Möglichkeit anhand des sog. „AllmendeSpiels“ – auch „tragedy of the commons“ genannt[80] –, welches allerdings die Keen’sche Korrektur der GewinnmaximierungsStrategie nachhaltig stützt.[81] Steve Keen wiederum bespricht die spieltheoretisch interpretierbaren Aspekte seiner Theorie im Rahmen des sog. „Gefangenendilemmas“.[82] Er zeigt hierbei, dass unter der Voraussetzung wiederholter Spiele das neoklassische Gleichgewicht instabil wird, denn nun können Unternehmen selbst unter den idealen Voraussetzungen eines „Gefangenendilemmas“ aufgrund der Effekte ihrer Mengenvariationen erkennen, welche Strategie gewinnmaximierend ist und diese Strategie realisieren.[83] Wie Keen anhand konkreter, leicht universalisierbarer Zahlenbeispiele[84] und genereller Iterationsmodelle[85] aufzeigt, bietet der spieltheoretische Zugang auf keinen Fall einen brauchbaren Ausweg für das neoklassische Wettbewerbsmodell, sondern umgekehrt die letzte Sackgasse. 5. Resümee § 18. Die neoklassische Unternehmenstheorie und mit ihr wesentliche Teile der Theorie der (kapitalistischen) Produktion wurden bereits in den zwanziger Jahren des 20. Jahrhunderts einer sehr radikalen und logisch überzeugenden Grundsatzkritik durch den Ökonomen Piero Sraffa unterworfen. Im Ergebnis konnte Sraffa zeigen, dass die bis heute übliche Konstruktion besonders der Angebotskurve der Unternehmen auf einer nicht haltbaren Kostentheorie beruht. Ferner sah Sraffa das Theorem des „vollkommenen Wettbewerbs“ als in Folge der Probleme der Kostentheorie nicht haltbar an, da es nicht mit den in der Industrieproduktion häufig auftretenden steigenden Erträgen (also sinkende Kosten) vereinbar ist. Die einzige Möglichkeit, den „vollkommenen Wettbewerb“ zu retten wäre die Annahme konstanter Ertragszuwächse, mit der aber das Prinzip von Angebot und Nachfrage zur Ermittlung der Marktpreise hinfällig wird und faktisch die klassische Nationalökonomie – also David Ricardo und je nach Lesart auch Karl Marx – mit ihrer Betonung der Produktionskosten (resp. Arbeitswerte) für die relativen Preise rehabilitiert wird. Für die Annahme konstanter bzw. steigender Erträge sprechen hierbei alle größeren empirischen Untersuchungen.[86] Sraffas Kritik wurde in neuerer Zeit bestätigt durch den Ökonomen Steve Keen, welcher der mathematischen Formalisierung der Theorie des „vollkommenen Wettbewerbs“ offenkundige Fehler nachweisen konnte, die das Gebäude irreparabel beschädigen. In den sechziger Jahren wiederum wurde auf Basis seines Hauptwerkes der Nachweis erbracht, dass die neoklassische Kapitaltheorie – und mit ihr die neoklassische Verteilungstheorie – nicht haltbar ist außerhalb des extrem realitätsfernen Falls einer „EinGutÖkonomie“. In einem ökonomischen System mit beliebig vielen Kapitalgütern wiederum können aufgrund der Verflechtung der Produzenten selbst unter neoklassischen Idealbedingungen Effekte – wie die erläuterten Effekte der „Kapitalreversion“ und der „Wiederkehr der Technik“ – auftreten, welche die gesamte Verteilungslehre und mit ihr die Arbeitsmarkttheorie sowie die generelle Theorie des „Knappheitspreises“ destruieren. Im Endergebnis lässt Sraffas Kritik die neoklassische ökonomische Theorie – und mit ihr die herrschende, neoliberale Theorie der effizienten Märkte und der Wohlstandmehrung durch Marktöffnung und Deregulierung – in Trümmern zurück und weist durch ihre Kritik den Weg in eine andere Theorie, welche auf produktionstechnischen Zusammenhängen, ökonomischen Verflechtungsstrukturen und der Existenz eines dauerhaften Mehrprodukts aufbaut. Derartige Alternativen bestehen aber nur außerhalb des ökonomischen Mainstreams, nämlich bei postkeynesianischen Theoretikern[87] einerseits und Marxisten resp. Arbeitswerttheoretikern andererseits.[88] Literatur

Anmerkungen